- Nota sobre las palabras clave

- ¿Qué es exactamente la arquitectura serverless?

- Principios clave de diseño en serverless

- Patrones arquitectónicos comunes

- Ventajas de adoptar serverless

- Desventajas y retos a considerar

- Casos de uso ideales para serverless

- Comparativa práctica: serverless vs contenedores vs máquinas virtuales

- Criterios para decidir si serverless es adecuado

- Cómo empezar con serverless: pasos prácticos

- Checklist técnico al crear una función

- Herramientas y proveedores principales

- Costos y optimización

- Seguridad y observabilidad

- Buenas prácticas para despliegues y gobernanza

- Historias de éxito y ejemplos reales

- Errores comunes y cómo evitarlos

- El futuro de serverless

- Recursos prácticos para profundizar

- Conclusión

He aquí un tema que suena a magia moderna: construir aplicaciones sin tener que preocuparte por servidores físicos, mantenimiento de máquinas virtuales, ni por el encendido y apagado de infraestructura. La arquitectura serverless no elimina los servidores; los abstrae. Pero esa abstracción cambia la forma en que diseñamos, desplegamos y operamos software. En las siguientes páginas te llevaré de la mano por qué tantas empresas, desde startups hasta grandes corporaciones, están adoptando este enfoque, cuáles son sus ventajas y trampas, y cómo puedes empezar hoy mismo a pensar en aplicaciones pensadas para serverless. Quiero que te quedes con ideas prácticas, patrones reutilizables y una buena intuición para decidir cuándo serverless es la opción correcta y cuándo no lo es.

Nota sobre las palabras clave

No se proporcionó una lista explícita de frases clave por escrito; sin embargo, a lo largo del texto utilizaré términos y expresiones habituales en el ecosistema serverless (funciones como servicio, eventos, cold start, escalado automático, proveedores de funciones, etc.) de manera natural y uniforme para que el artículo tenga coherencia y utilidad práctica.

¿Qué es exactamente la arquitectura serverless?

La arquitectura serverless es un modelo de computación donde los desarrolladores escriben código y el proveedor de la nube se encarga de ejecutar ese código sin que el desarrollador gestione servidores. En la práctica esto significa que despliegas piezas de lógica —generalmente funciones pequeñas y autónomas— y las llamas en respuesta a eventos: una petición HTTP, un cambio en una base de datos, la llegada de un mensaje a una cola, o un cron job programado. No te preocupas por el sistema operativo, el parcheo de seguridad ni por el escalado de instancias; pagas por la ejecución real y el proveedor ajusta la capacidad automáticamente.

Imagina que tu aplicación es una orquesta: antes, tú eras el director y también afinabas cada instrumento, limpiabas los micrófonos y controlabas las luces; con serverless, eres el compositor que entrega partituras (funciones) y el proveedor se ocupa del resto del montaje, la acústica y la logística técnica. Esto libera tiempo para centrarte en la lógica de negocio y la experiencia del usuario.

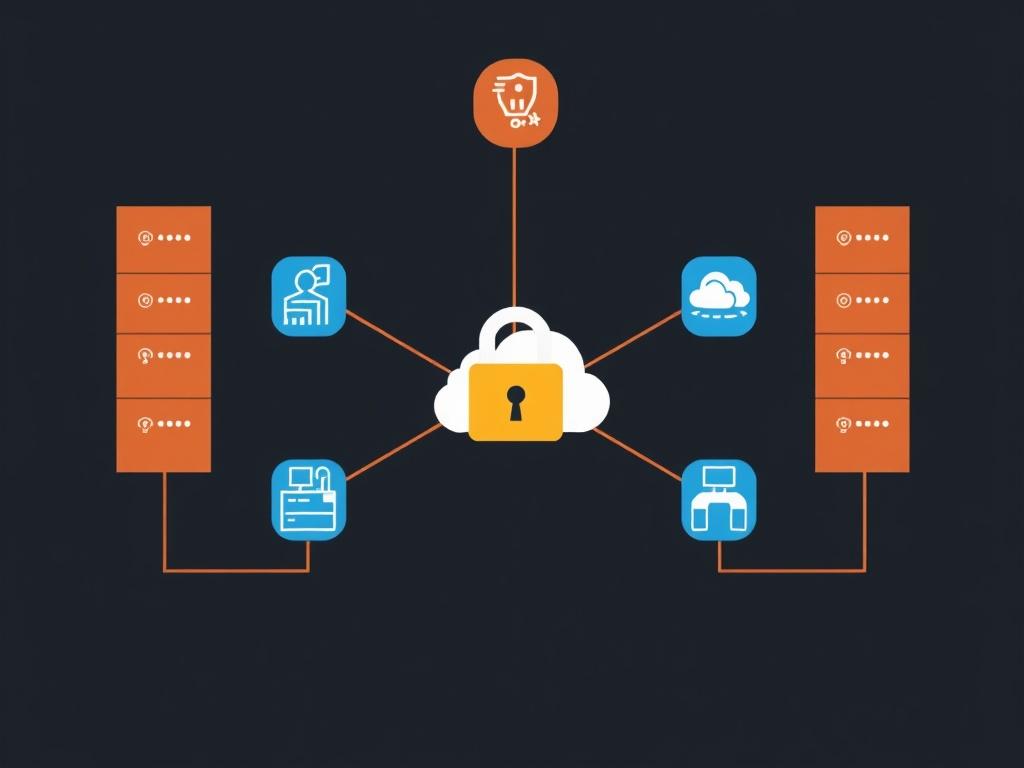

Desde el punto de vista técnico, las piezas más comunes en un sistema serverless incluyen funciones como servicio (FaaS), almacenamiento gestionado, bases de datos serverless, colas y brokers de eventos, y servicios manejados para autorización y observabilidad. La combinación de estos componentes permite construir aplicaciones compuestas por pequeñas piezas que se comunican mediante eventos y APIs.

Principios clave de diseño en serverless

Diseñar para serverless no es solo trasladar código que ya existía hacia funciones; requiere pensar en granularidad, idempotencia, latencia esperada y en cómo manejar estados. Un principio es «funciones pequeñas y enfocadas»: una función debe hacer una cosa clara y hacerla bien. Esto facilita pruebas, despliegue independiente y escalado eficiente.

Otro principio es «event-driven»: las aplicaciones serverless funcionan mejor cuando están orientadas a eventos. Los eventos pueden ser HTTP, cambios en objetos de almacenamiento, notificaciones de base de datos o mensajes en colas. Diseñar flujos asíncronos y tolerantes a fallos se convierte en una habilidad clave.

La idempotencia es crítica. Dado que eventos pueden reintentarse o duplicarse, las funciones deben poder ejecutarse varias veces sin causar efectos adversos. Esto obliga a considerar transacciones, comprobaciones previas y mecanismos de deduplicación.

También es importante pensar en «desacoplamiento». En vez de que los componentes se llamen entre sí directamente y esperen respuestas síncronas, es frecuente usar colas, temas de eventos o almacenamiento intermedio para hacer la comunicación más resiliente y escalable. El desacoplamiento reduce la fragilidad y facilita la evolución independiente de cada pieza.

Finalmente, la observabilidad debe diseñarse desde el principio. En un entorno donde las funciones aparecen y desaparecen según la demanda, necesitas trazas distribuidas, métricas y logs centralizados para entender el comportamiento del sistema.

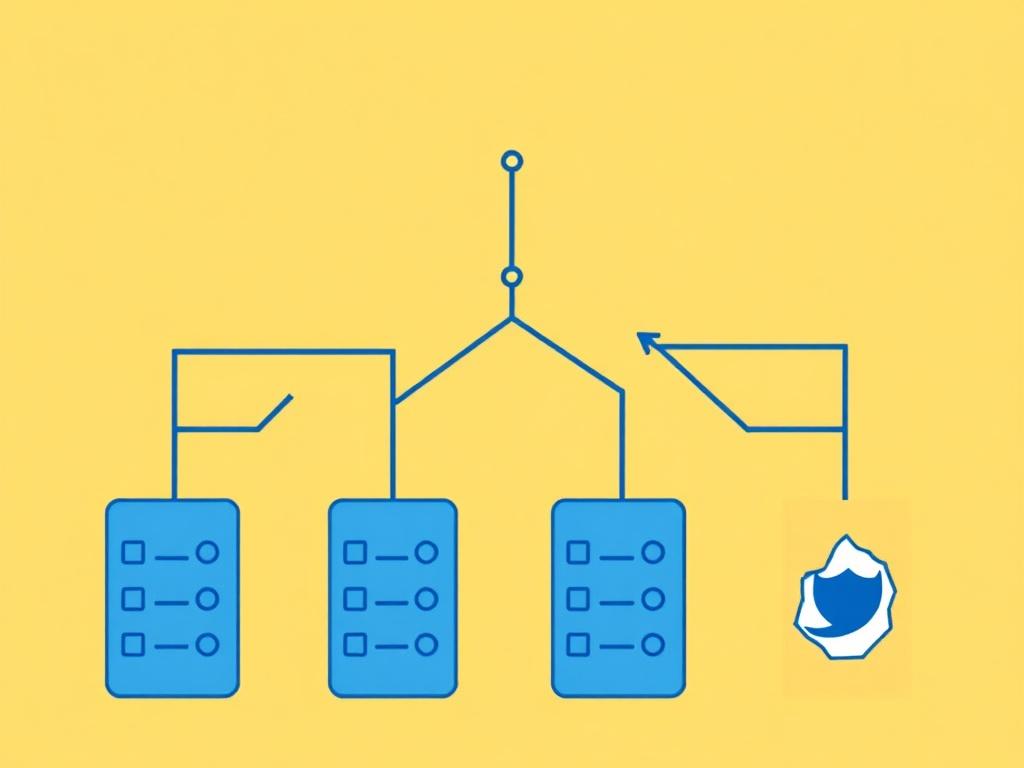

Patrones arquitectónicos comunes

Existen patrones que se repiten en muchas aplicaciones serverless y que facilitan la escalabilidad y el mantenimiento. Entre ellos están:

- API Backend con funciones: cada endpoint HTTP desencadena una función específica para manejar la petición.

- Pipeline de procesamiento de eventos: eventos entrantes pasan por una cadena de funciones que procesan, transforman y almacenan datos.

- Microservicios orientados a eventos: servicios pequeños que se comunican mediante eventos, manteniendo estado local sólo cuando es necesario.

- Trabajos programados (cron) con funciones: tareas periódicas como limpieza de datos o generación de reportes ejecutadas por funciones serverless.

- Pipelines ETL serverless: extracción, transformación y carga de datos en lotes o en streaming empleando funciones para cada paso.

Cada patrón aporta ventajas específicas y también desafíos particulares (latencia, límites de ejecución, o consistencia).

Ventajas de adoptar serverless

Adoptar serverless trae ventajas que no se limitan a ahorro en costos: también cambia la organización del trabajo y acelera la entrega de valor. Aquí detallo las más relevantes y la razón por la que importan.

En primer lugar, la reducción de la carga operacional es enorme. Si antes dedicabas equipos al mantenimiento, parches, configuración de autoscaling y monitorización de instancias, ahora gran parte de eso lo hace el proveedor. Esto permite que los equipos de desarrollo se concentren en features, experiencia de usuario y diferenciación.

El escalado automático es otra ventaja potente: la infraestructura escala hacia arriba y hacia abajo en función de la demanda real, a menudo con latencias de escalado muy rápidas. Esto es especialmente útil para aplicaciones con picos impredecibles de tráfico o para startups que no quieren sobreprovisionar recursos.

La facturación basada en consumo también es atractiva: pagas por tiempo de ejecución y recursos consumidos, no por capacidad preasignada. Esto puede reducir costes significativamente para cargas intermitentes y proyectos pilotos.

Además, el time-to-market empeora positivamente: con servicios gestionados puedes armar prototipos y lanzar productos mucho más rápido. Combinado con despliegues continuos y pruebas automáticas, el ciclo de feedback se acorta.

Por último, la arquitectura serverless facilita la adopción de patrones modernos como event-driven, microservicios y compuestos de servicios gestionados, lo que potencia la flexibilidad y permite enfocarse en la lógica de negocio.

Desventajas y retos a considerar

Como toda tecnología, serverless no es una panacea. Tiene limitaciones técnicas, riesgos en costes y consideraciones organizativas que conviene evaluar con frialdad.

Un reto técnico frecuente es el cold start: cuando una función no ha sido ejecutada en un tiempo, el entorno subyacente puede tardar en iniciarse, lo que añade latencia a la primera petición. Esto puede ser molesto en aplicaciones con requisitos estrictos de latencia y se agrava con runtimes pesados o dependencias grandes.

Los límites en tiempo de ejecución, memoria y concurrencia son otra preocupación. Muchas plataformas serverless imponen límites máximos (por ejemplo, ejecución máxima de varios minutos). Las tareas de larga duración o los procesos intensivos en CPU/Memoria pueden no encajar bien y requerir arquitecturas híbridas.

La facturación por consumo también puede sorprender si no se diseña con cuidado. En aplicaciones con millones de invocaciones pequeñas, los costes por invocación e I/O pueden acumularse. Además, las llamadas a servicios externos, almacenamiento y transferencias de datos también impactan.

La observabilidad y el debugging en producción requieren herramientas adecuadas: rastrear llamadas distribuidas entre funciones efímeras no es trivial. Necesitarás trazas distribuidas, correlación de logs y métricas agregadas para diagnosticar y optimizar.

Otro punto es la dependencia del proveedor (vendor lock-in). El uso intensivo de servicios específicos de un proveedor puede dificultar la migración futura. Mitigar este riesgo implica diseñar interfaces limpias, abstraer puntos de integración y comprender las alternativas.

Finalmente hay retos organizativos: pasar a serverless cambia flujos de trabajo, despliegue y testing. Requiere formación del equipo y adaptaciones en CI/CD, gobernanza y seguridad.

Casos de uso ideales para serverless

Serverless brilla en muchos escenarios. Aquí te describo casos donde suele ser una opción excelente:

- APIs RESTful y GraphQL con tráfico variable: se aprovecha el escalado automático y el pago por ejecución.

- Backends para aplicaciones móviles: procesamiento de eventos, notificaciones y transformaciones ligeras.

- Procesamiento de eventos en tiempo real: ingestión y trasformación de datos desde IoT, logs o streams.

- Automatización y cron jobs: tareas periódicas que no requieren una máquina siempre encendida.

- Pipelines ETL y procesamiento por lotes pequeños: cuando la carga puede dividirse en unidades de trabajo manejables.

- Microservicios con baja latencia de puesta en marcha: funcionalidades independientes que pueden escalar por separado.

Si tu aplicación tiene requisitos de latencia muy estrictos, tareas de computación de larga duración o depende de software muy específico en el sistema operativo, quizá un enfoque híbrido (serverless + contenedores/VMs dedicadas) sea más apropiado.

Comparativa práctica: serverless vs contenedores vs máquinas virtuales

A continuación verás una tabla sencilla que resume diferencias clave para ayudar en la toma de decisiones:

| Aspecto | Serverless (FaaS) | Contenedores (Kubernetes) | Máquinas virtuales |

|---|---|---|---|

| Gestión de infra | Baja (proveedor gestiona) | Moderada (orquestador requiere operación) | Alta (gestión completa) |

| Escalado | Automático por invocación | Automático/Manual (configurable) | Manual o mediante autoscaling complejo |

| Costo | Pago por uso (beneficioso para ráfagas) | Coste constante según nodos | Coste alto si sobredimensionado |

| Latencia | Puede verse afectada por cold starts | Controlada (más consistente) | Consistente pero con overhead de VM |

| Compatibilidad de software | Limitada a runtime soportado | Amplia (cualquier contenedor) | Máxima (control total) |

Criterios para decidir si serverless es adecuado

No se trata de elegir serverless por moda, sino por criterio. Pregúntate: ¿mi aplicación tiene picos de carga o tráfico impredecible? ¿Puedo dividir la lógica en unidades pequeñas y sin estado? ¿Mis requisitos de latencia toleran posibles cold starts? ¿Mi equipo está dispuesto y puede invertir en las prácticas de observabilidad y testing necesarias? Si la respuesta a las primeras preguntas es sí y tienes flexibilidad en las últimas, serverless puede acelerar tu proyecto y reducir costes operativos.

También evalúa el riesgo de vendor lock-in: si existe una alta probabilidad de migrar de proveedor, diseña abstracciones claras y evita depender excesivamente de servicios propietarios salvo que el beneficio compense el coste de lock-in.

Cómo empezar con serverless: pasos prácticos

Comenzar no tiene por qué ser aterrador. Sigue estos pasos prácticos:

- Identifica una pieza de la aplicación con bajo riesgo para migrar, por ejemplo, un endpoint API sencillo o una tarea programada.

- Define los eventos que desencadenarán funciones y diseña la entrada/salida de cada función de forma clara.

- Empieza con funciones pequeñas y bien testeables; evita llevar código monolítico tal cual—refactoriza.

- Configura pipeline de CI/CD para despliegue automático de funciones y pruebas unitarias/integradas.

- Implementa observabilidad desde el primer día: logs estructurados, métricas y trazas distribuidas.

- Mide coste y rendimiento durante un periodo; ajusta memoria y configuraciones según necesidades.

- Itera: amplía gradualmente otras partes del sistema a medida que domines las prácticas y herramientas.

Estas acciones minimizan el riesgo y te permiten aprender sin comprometer la totalidad de tu stack.

Checklist técnico al crear una función

Aquí tienes una lista rápida de verificación antes de desplegar una función:

- Declarar tiempos de ejecución y memoria adecuados.

- Manejar errores y reintentos de forma explícita.

- Loguear con contexto identificable (requestId, traceId).

- Validar entradas y salidas para evitar fallos silenciosos.

- Evitar dependencias pesadas en tiempo de ejecución.

- Agregar pruebas unitarias y pruebas de integración en CI.

- Documentar claramente el contrato del evento que la invoca.

Herramientas y proveedores principales

El ecosistema serverless está dominado por proveedores en la nube que ofrecen funciones como servicio y muchos servicios gestionados complementarios. Aquí tienes una tabla comparativa con los jugadores más conocidos y cuándo considerarlos:

| Proveedor | Producto principal | Fortalezas | Cuándo usarlo |

|---|---|---|---|

| AWS | AWS Lambda (+ API Gateway, DynamoDB, SQS) | Amplio ecosistema, integración profunda con servicios gestionados | Si necesitas variedad de servicios gestionados y escala masiva |

| Google Cloud | Cloud Functions / Cloud Run | Buen soporte para cargas de datos y ML, integración con BigQuery | Si trabajas intensamente con datos y quieres integración con GCP |

| Azure | Azure Functions | Integración con servicios Microsoft y herramientas empresariales | Cuando la organización ya usa Microsoft a gran escala |

| Cloudflare | Cloudflare Workers | Baja latencia global, edge computing | Si necesitas lógica en el edge y baja latencia global |

| Vendors serverless especializados | Netlify Functions, Vercel Functions | Despliegue sencillo enfocado en frontend y JAMstack | Proyectos web estáticos o frontend con backend ligero |

Cada proveedor ofrece modelos de facturación y límites distintos; estudia la documentación y planifica pruebas de carga para entender el comportamiento en tu escenario.

Costos y optimización

Optimizar costos en serverless requiere entender los factores que generan facturación: tiempo de ejecución, memoria asignada, número de invocaciones, I/O, y servicios complementarios (almacenamiento, base de datos, transferencias). Para optimizar:

- Asigna memoria adecuadamente: más memoria a menudo reduce el tiempo de ejecución, pero sube el coste por unidad de tiempo; encuentra el punto óptimo.

- Reduce el tamaño de las dependencias para minimizar el tiempo de cold start.

- Utiliza cache cuando tenga sentido para evitar llamadas repetidas a servicios externos.

- Consolida invocaciones: agrupa operaciones en una sola llamada cuando la latencia lo permita para reducir número de invocaciones.

- Monitoriza y alerta sobre patrones de incremento de costes—un spike puede significar un bug.

A continuación una tabla con ejemplos de factores que impactan coste:

| Factor | Impacto en coste | Cómo mitigar |

|---|---|---|

| Alta frecuencia de invocaciones | Coste por invocación crece | Agrupar peticiones, usar lotes |

| Funciones con tiempo de ejecución largo | Mayor consumo de tiempo x memoria | Optimizar código, offload a servicios gestionados |

| Transferencias de datos entre regiones | Costes por salida de red | Alinear servicios en una misma región |

| Dependencias grandes (cold starts) | Latencia y ejecución extra | Reducir dependencias, usar capas o runtimes más ligeros |

Seguridad y observabilidad

La seguridad en serverless exige políticas y controles finos. Como cada función suele tener permisos para interactuar con servicios, aplica el principio de menor privilegio: cada función debe tener sólo los permisos estrictamente necesarios. Además, asegúrate de manejar secretos de forma segura mediante gestores de secretos y evita almacenarlos en variables de entorno sin cifrar.

La gestión de límites y cuotas también es una medida de protección: configurar límites de concurrencia puede evitar que una función maliciosa o un pico de tráfico agote recursos y cause facturas inesperadas.

En observabilidad, centraliza logs y emplea trazas distribuidas para rastrear el flujo entre funciones. Herramientas de APM y tracing (como OpenTelemetry) facilitan correlacionar eventos y diagnosticar latencias. Define métricas clave (latencia 95/99, tasa de errores, duración promedio) y crea dashboards para seguimiento.

No olvides tests de resiliencia: simula reintentos, latencia en servicios externos y fallos parciales para verificar que el sistema se recupera sin pérdida de datos.

Buenas prácticas para despliegues y gobernanza

Adoptar serverless a escala requiere gobernanza. Define estándares para nombrado de funciones, límites de recursos, políticas de seguridad y revisiones de arquitectura. Automatiza despliegues con pipelines que incluyan pruebas, escaneos de seguridad y validaciones de configuración. Fija políticas de retención de logs y límites de permisos automáticos para evitar proliferación de funciones con exceso de privilegios.

Historias de éxito y ejemplos reales

Muchas empresas usan serverless con resultados espectaculares. Startups que escalaron sin preocuparse por infraestuctura, productos que pudieron soportar picos masivos en días de lanzamiento, o equipos que redujeron el time-to-market pasando a un modelo FaaS. Los casos de uso más repetidos incluyen backends para apps móviles con millones de usuarios, procesamiento de eventos para pipelines de datos y APIs públicas de alto tráfico.

Uno de los aspectos inspiradores de estos ejemplos es cómo equipos pequeños alcanzaron impacto grande: al eliminar la carga operativa, dedicaron tiempo a mejoras de producto, experiencia de usuario e innovación.

Errores comunes y cómo evitarlos

Al migrar a serverless, se cometen errores frecuentes: mover un monolito a una sola función sin refactorizar, ignorar la gestión de dependencias y cold starts, descuidar la observabilidad, o no entender la facturación por invocación. Evítalos con pequeñas pruebas pilotos, revisiones de arquitectura, y métricas desde el inicio.

También es común confiar ciegamente en el proveedor sin medir el coste a largo plazo: realiza proyecciones de coste con datos reales y pruebas de carga antes de comprometerse plenamente.

El futuro de serverless

El modelo serverless sigue evolucionando: edge computing, funciones más cercanas al usuario para reducir latencia global, runtimes más eficientes y mejores herramientas de observabilidad y debugging. Veremos además una convergencia entre contenedores y serverless, con plataformas que permiten ejecutar contenedores con la experiencia de FaaS y costos ajustados por uso.

La tendencia es clara: abstraer más complejidad de la infraestructura para que los equipos se centren en lo que importa: crear valor. Con la maduración de herramientas y patrones, muchos de los retos actuales se mitigarán, haciendo que serverless sea una opción aún más atractiva para una gama más amplia de aplicaciones.

Recursos prácticos para profundizar

Si quieres seguir aprendiendo, aquí tienes una lista de recursos prácticos que te serán útiles:

- Documentación oficial de proveedores (AWS Lambda, Azure Functions, Google Cloud Functions).

- Guías de patrones serverless (serverless.com, arquitecturas de referencia).

- Herramientas de framework: Serverless Framework, Claudia.js, SAM (AWS), Azure Functions Core Tools.

- Material sobre observabilidad y tracing distribuido (OpenTelemetry).

- Tutoriales de integración con bases de datos serverless y servicios gestionados.

Estos recursos te permitirán experimentar, comparar y encontrar la combinación de herramientas que mejor se adapte a tus necesidades.

Conclusión

La arquitectura serverless ofrece una forma potente y eficiente de construir aplicaciones modernas: reduce la carga operativa, permite escalar dinámicamente y acelera el time-to-market, pero exige un rediseño consciente de la aplicación hacia funciones pequeñas, tolerantes a fallos y orientadas a eventos, así como disciplina en observabilidad, seguridad y gestión de costos; si decides adoptarla, comienza por piezas de bajo riesgo, automatiza despliegues, mide resultados y ajusta según datos reales, porque cuando se usa con criterio serverless puede transformar la forma en que tu equipo entrega valor, pero exige también comprensión de sus límites y la adopción de buenas prácticas para sacar el máximo provecho.

Как вам статья?